Por cada usuario de Google Analytics es importante distinguir el tráfico de Internet de un sitio web - lo real de lo artificial. Hay programas de ordenador diseñados para realizar tareas automáticas a través de Internet, llamados Bots, que puede generar una gran cantidad de tráfico en un sitio web. Así, En este artículo usted aprenderá lo que puede hacer, excluir que el tráfico general no deseado.

Al final del año pasado, hubo informes oficiales que establecen que solamente alrededor "50% del tráfico web"Viene de los seres humanos reales. Eso es un problema, especialmente con tantos "Motores de búsqueda"En torno a que puede obstaculizar en saber lo que es el verdadero tráfico para cualquiera de sus sitios web.

Motores de búsqueda de Internet están diseñados para realizar tareas simples y repetitivas de forma automática, que son tediosas o imposible que la gente haga. El mayor uso de tales "Motores de búsqueda" es en Spidering Web. LA "Araña", también conocido como "Rastreador Web"Es un script que obtiene, análisis y archivos de información específica de los servidores web mucho más rápido que cualquier ser humano puede hacer. Se llama así porque se arrastra a través de Internet.

En el pasado una manera eficiente de detener la influencia de los robots sobre estadísticas de tráfico fue para Google Analítico para usar JavaScript, como los robots no podían. Hoy en día hay incluso los robots "inteligentes", que se puede utilizar con éxito JavaScript, y bypass que la técnica en la prevención Google Analítico.

Además de tales robots de, existen los 'malos'. Algunos robots están diseñados para provocar "Negación de servicio (DoS)"Ataques, mientras que otros de Mensajes Spam no vinculados en sus sitios con enlace que puede contener contenido malicioso, que son otras razones válidas para no querer bot-rastreadores en sus páginas web.

Aquí están 5 métodos para excluir todo el bot genera tráfico de Google Analytics:

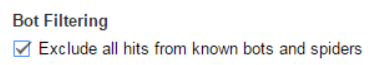

Método #1 - Habilitar Bot filtrado desde el panel de administración

Hay una casilla dentro de Google Analytics que puede ser marcada para eliminar los robots conocidos. Se encuentra dentro de la "Administración" panel, debajo "Ver"Los ajustes y la casilla de verificación se denomina"Bot Filtrado". Se recomienda hacer primero una Prueba Ver, antes de salir de la casilla marcada en el informe principal Ver. De esa manera se puede detectar lo que las diferencias que se dará cuenta en los resultados de la recopilación de datos.

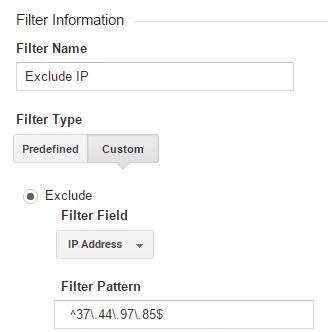

Método #2 – Filtro de direcciones IP específicas

Las direcciones IP no se muestran en Google Analítico informes. Tampoco son disponibles para ser visto a través de JavaScript por defecto, pero usted debería ser capaz de configurar y activar esta característica en su sitio con bastante facilidad. Después de haber recuperado todas las direcciones IP que desea excluir de la que se analiza en los datos de tráfico de Internet, es el momento de bloquear aquellos. Puede hacerlo utilizando el "Ver Filtros"Menú dentro Google Analítico.

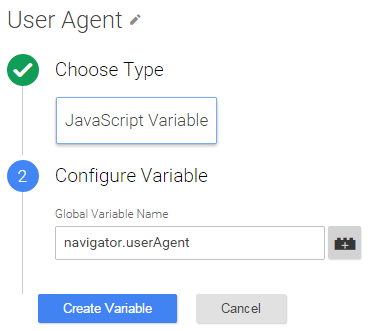

Método #3 - Adición de una variable JavaScript para agentes de usuario

Incluso si bloquea IPs específicas, algunos bots pueden utilizar varias direcciones IP y cambiar entre ellas. Con la ayuda de "Google Tag Administrador"Es posible pasar de todo “Agente de usuario” instrumentos de cuerda dentro Google Analítico como una dimensión personalizada. Después, puede excluir sesiones bots '.

Crear un "Dimensión personalizada" en el "Administración"Panel de Google Analítico. Asegúrese de que el nombre es "Agente de usuario"Y que el alcance"Sesión". Abandonar "Índice"Sin tocar por ahora.

En Google Tag Administrador estableció un nuevo "Variable JavaScript" con navigator.userAgent valor.

Establezca una ranura variable personalizada para su "Google Analytics Pageview Tag", utilizando el anteriormente mencionado "Índice". Introducir el {{Agente de usuario}} en la variable "Valor Dimensión".

En "Admin> Ver> Filtros"Usted puede eliminar"Agentes de usuario", Que se sabe que son los robots, debido a su comportamiento extraño, al igual que los usuarios que tienen tasas de rebote repetición u otros usuarios que tienen cientos de visitas por día.

Método #4 - Añadir un Requisito de CAPTCHA

Para hacer las cosas más difíciles para los robots que aún están entrando en su sitio a pesar de las medidas cautelares previas tomadas, usted debe utilizar una especie de "Captcha". Se recomienda el uso de Google de la propia "reCAPTCHA"El servicio y la nueva variante llamada"noCAPTCHA". Detecta el comportamiento humano que es típico, incluyendo el uso del ratón, lo que permite a las personas que no tienen la necesidad de introducir un mensaje código de imagen en absoluto.

Método #5 - Exigir a los usuarios validar su correo electrónico

Los usuarios deben ser obligados a introducir una dirección de correo electrónico válida, comprobar su correo electrónico, y haga clic en el enlace de confirmación con un mensaje que dijiste. Hay Motores de búsqueda muy sofisticados que pueden incluso hacer que, así que una última cosa que debe hacer es añadir un "reCAPTCHA" aquí también. Tal una con reconocimiento de imágenes:

Esto debe resumir las maneras más efectivas para excluir todos los éxitos de Motores de búsqueda de Internet y arañas en Google Analítico para su sitio(s). Usted debe ver un cambio notable en su recolección de datos los resultados de análisis, después de la aplicación de todos y cada método descrito anteriormente. Y también puede prevenir Los ataques DDoS contra los robots maliciosos, así. Así, para resumir, todos estos métodos son una manera viable para luchar contra los robots y son necesarios para todos los Google Analítico usuario.