Diep zoeken, een snelgroeiende Chinese kunstmatige intelligentie (AI) startup die onlangs veel aandacht heeft gekregen, onbedoeld een van zijn databases online openbaar heeft gemaakt. Deze beveiligingsfout had cybercriminelen toegang kunnen geven tot zeer gevoelige informatie.

Volgens beveiligingsonderzoeker Gal Nagli van Wiz, de verkeerd geconfigureerde ClickHouse-database verleende volledige administratieve controle, het mogelijk maken voor onbevoegde gebruikers om zonder beperkingen toegang te krijgen tot interne gegevens.

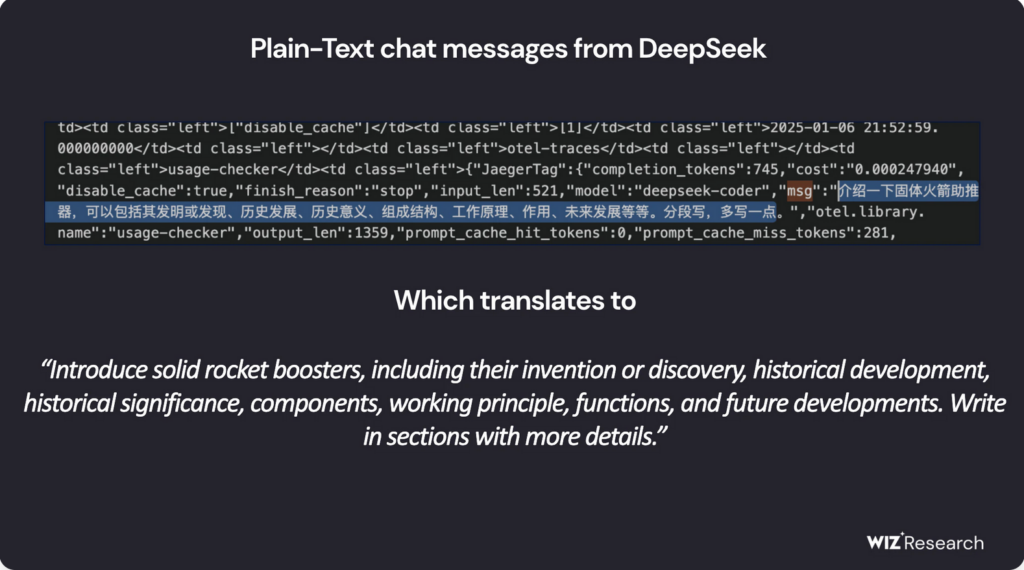

De blootgestelde database zou het volgende bevatten: meer dan een miljoen regels logstreams, inclusief chatgeschiedenissen, backend-details, API-geheimen, geheime sleutels, en andere kritieke operationele metadata. Na meerdere contactpogingen van Wiz, DeepSeek heeft de kwetsbaarheid inmiddels gedicht.

Het is de moeite waard om te vermelden dat op het moment dat dit artikel werd gepubliceerd, we konden ons niet registreren voor de service van DeepSeek AI, toen het volgende bericht verscheen:

DeepSeek biedt onbeperkte toegang tot gevoelige gegevens

De gecompromitteerde database, gehost op oauth2callback.deepseek[.]met:9000 en dev.deepseek[.]met:9000, onbeperkte toegang tot een breed spectrum aan vertrouwelijke gegevens. Wiz-onderzoekers waarschuwden dat de blootstelling tot volledige controle over de database had kunnen leiden, ongeoorloofd privilege escalatie, en data-exploitatie – zonder dat er enige authenticatie nodig is.

Bovendien, aanvallers hadden de HTTP-interface van ClickHouse kunnen gebruiken om SQL-query's uitvoeren rechtstreeks vanuit een webbrowser. Op dit punt, het blijft onzeker of kwaadwillende actoren erin geslaagd zijn om de blootgestelde gegevens te infiltreren of te extraheren voordat het probleem werd opgelost.

“De snelle adoptie van AI-diensten zonder adequate veiligheidsmaatregelen brengt ernstige risico’s met zich mee,"Nagli verklaarde in een commentaar aan The Hacker News. "Terwijl discussies over AI-beveiliging zich vaak richten op langetermijnbedreigingen, “Directe gevaren vloeien vaak voort uit fundamentele veiligheidsoversights, zoals onbedoelde blootstelling van databases.”

Hij benadrukte verder dat het beschermen van gebruikersgegevens een topprioriteit moet blijven, veiligheidsteams aansporen om nauw samen te werken met AI-ontwikkelaars om soortgelijke incidenten in de toekomst te voorkomen.

DeepSeek onder toezicht van toezichthouders

DeepSeek heeft onlangs erkenning gekregen voor zijn geavanceerde open-source AI-modellen, zichzelf positionerend als een geduchte concurrent voor leiders in de industrie zoals OpenAI. Het R1-redeneringsmodel wordt het ‘Sputnik-moment van AI’ genoemd vanwege het potentieel om de wereld te veranderen..

De AI-chatbot van het bedrijf is enorm populair geworden, bovenaan de app store-ranglijsten op zowel Android als iOS in meerdere landen. Echter, de snelle expansie ervan heeft het ook tot een doelwit gemaakt voor grootschalige cyberaanvallen, DeepSeek ertoe aanzetten om gebruikersregistraties tijdelijk op te schorten om beveiligingsrisico's te beperken.

Verder dan technische kwetsbaarheden, het bedrijf heeft ook toezicht van de toezichthouder gekregen. Privacyzorgen rondom DeepSeek's datapraktijken, gekoppeld aan zijn Chinese oorsprong, hebben nationale veiligheidsalarmen in de Verenigde Staten doen afgaan.

Juridische uitdagingen

In een belangrijke ontwikkeling, De Italiaanse toezichthouder op gegevensbescherming heeft onlangs om details gevraagd over de methoden voor gegevensverzameling en trainingsbronnen van DeepSeek. Kort daarna, de apps van het bedrijf zijn niet meer beschikbaar in Italië, hoewel het onduidelijk blijft of deze stap een direct antwoord was op toezichthoudende onderzoeken.

Ondertussen, DeepSeek wordt ook beschuldigd van het op oneigenlijke wijze gebruiken van de Application Programming Interface van OpenAI (API) om eigen modellen te ontwikkelen. Rapporten van Bloomberg, De Financiële Times, en The Wall Street Journal geven aan dat zowel OpenAI als Microsoft onderzoeken of DeepSeek zich bezighoudt met een ongeoorloofde praktijk die bekendstaat als AI-distillatie, een techniek waarbij modellen worden getraind op basis van de uitkomsten die door een ander AI-systeem worden gegenereerd..

Meer over AI-destillatie

AI-distillatie, ook gekend als kennis distillatie, is een techniek in machinaal leren waarbij een kleinere, efficiënter AI-model wordt getraind met behulp van de uitkomsten van een groter, complexer model. Met deze methode kunnen ontwikkelaars kennis overdragen van een krachtige AI (het leraarmodel) naar een lichtgewicht AI (het studentenmodel) terwijl de mogelijkheden behouden blijven.

Oorspronkelijk ontworpen om de efficiëntie te verbeteren en de rekenkosten te verlagen, distillatie is een veelgebruikte praktijk geworden in de AI-ontwikkeling. Echter, wanneer dit gebeurt zonder de juiste autorisatie – zoals het extraheren van kennis uit gepatenteerde AI-modellen – roept dit ernstige ethische en juridische zorgen op.

“Wij zijn ons ervan bewust dat groepen in [China] werken actief aan repliceer geavanceerde VS. AI-modellen door technieken zoals distillatie," vertelde een vertegenwoordiger van OpenAI aan The Guardian.

Met de snelle groei van DeepSeek in de AI-sector, zorgen over de veiligheid ervan, naleving van regelgeving, en ethische datapraktijken zijn geïntensiveerd. De aanpak van het bedrijf op deze kwesties zal een sleutelfactor zijn in het vormgeven van zijn succes op de lange termijn in het wereldwijde AI-landschap.