DeepSeek, en hurtigt voksende kinesisk kunstig intelligens (AI) startup, der på det seneste har fået stor opmærksomhed, uforvarende forlod en af dens databaser eksponeret online. Dette sikkerhedsbrud kunne have givet cyberkriminelle adgang til meget følsomme oplysninger.

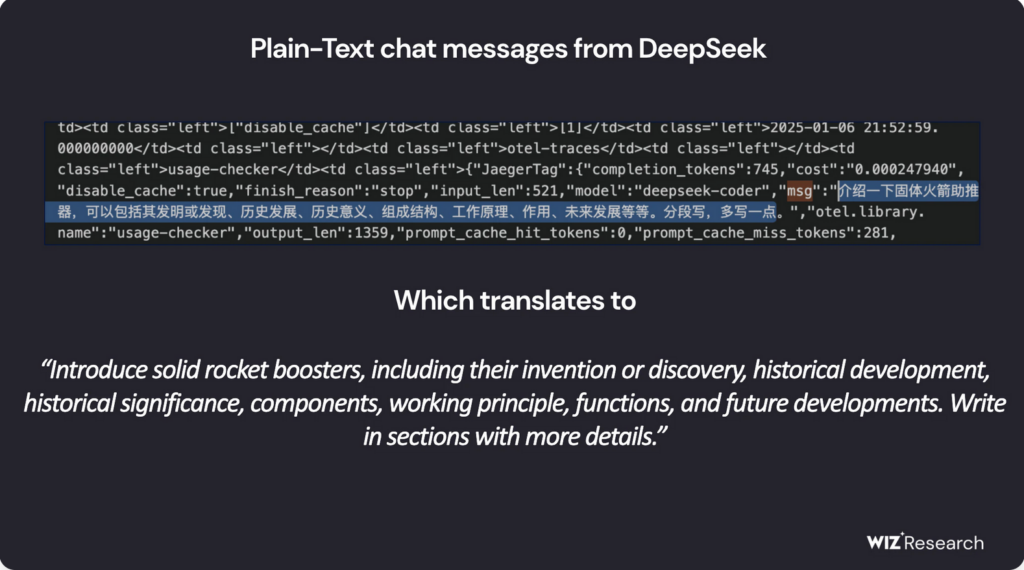

Ifølge sikkerhedsforsker Gal Nagli fra Wiz, den forkert konfigurerede ClickHouse-database gav fuld administrativ kontrol, gør det muligt for uautoriserede brugere at få adgang til interne data uden begrænsninger.

Den afslørede database indeholdt angiveligt over en million linjer log-streams, herunder chathistorier, backend detaljer, API hemmeligheder, hemmelige nøgler, og andre kritiske operationelle metadata. Efter flere kontaktforsøg fra Wiz, DeepSeek har siden sikret sårbarheden.

Det er værd at nævne, at på det tidspunkt, denne artikel blev offentliggjort, vi kunne ikke tilmelde os DeepSeek AI's service, som følgende besked dukkede op:

DeepSeek tillader ubegrænset adgang til følsomme data

Den kompromitterede database, hostet på oauth2callback.deepseek[.]med:9000 og dev.deepseek[.]med:9000, tilladt ubegrænset adgang til et bredt spektrum af fortrolige data. Wiz-forskere advarede om, at eksponeringen kunne have ført til fuldstændig databasekontrol, uberettiget privilegium eskalering, og dataudnyttelse – uden behov for nogen godkendelse.

Endvidere, angribere kunne have brugt ClickHouses HTTP-grænseflade til udføre SQL-forespørgsler direkte fra en webbrowser. På dette tidspunkt, det er fortsat usikkert, om nogen ondsindede aktører formåede at infiltrere eller udtrække de eksponerede data, før problemet blev løst.

"Den hurtige indførelse af AI-tjenester uden tilstrækkelige sikkerhedsforanstaltninger udgør alvorlige risici,” sagde Nagli i en kommentar til The Hacker News. “Mens diskussioner omkring AI-sikkerhed ofte fokuserer på langsigtede trusler, umiddelbare farer stammer ofte fra grundlæggende sikkerhedsforstyrrelser - såsom utilsigtet databaseeksponering."

Han understregede endvidere, at beskyttelse af brugerdata skal forblive en topprioritet, opfordrer sikkerhedsteams til at arbejde tæt sammen med AI-udviklere for at forhindre lignende hændelser i fremtiden.

DeepSeek under regulatorisk kontrol

DeepSeek har for nylig vundet anerkendelse for sine banebrydende open source AI-modeller, positionerer sig som en formidabel konkurrent til brancheledere som OpenAI. Dens R1-ræsonneringsmodel er blevet døbt "AI's Sputnik-øjeblik" for dets potentiale til at forstyrre feltet.

Virksomhedens AI-chatbot er steget i popularitet, topper app-butikkernes placeringer på både Android og iOS på tværs af flere lande. Men, dens hurtige ekspansion har også gjort det til et mål for store cyberangreb, beder DeepSeek om midlertidigt at suspendere brugerregistreringer for at afbøde sikkerhedstrusler.

Ud over tekniske sårbarheder, selskabet har også foretaget regulatorisk kontrol. Bekymringer om beskyttelse af personlige oplysninger omkring DeepSeeks datapraksis, sammen med dens kinesisk oprindelse, har rejst national sikkerhedsalarm i USA.

Juridiske udfordringer

I en markant udvikling, Italiens databeskyttelsesmyndighed anmodede for nylig om detaljer om DeepSeeks dataindsamlingsmetoder og træningskilder. Kort derefter, virksomhedens apps blev utilgængelige i Italien, selvom det stadig er uklart, om dette skridt var et direkte svar på lovgivningsmæssige forespørgsler.

I mellemtiden, DeepSeek står også over for beskyldninger om, at det kan have uretmæssigt udnyttet OpenAIs applikationsprogrammeringsgrænseflade (API) at udvikle sine egne modeller. Rapporter fra Bloomberg, Financial Times, og The Wall Street Journal angiver, at både OpenAI og Microsoft er ved at undersøge, om DeepSeek var involveret i en uautoriseret praksis kendt som AI-destillation - en teknik, der involverer træning af modeller på output genereret af et andet AI-system.

Mere om AI-destillation

AI destillation, også kendt som videndestillation, er en teknik i maskinlæring, hvor en mindre, mere effektiv AI-model trænes ved hjælp af output fra en større, mere kompleks model. Denne metode giver udviklere mulighed for at overføre viden fra en kraftfuld AI (lærermodellen) til en let AI (elevmodellen) samtidig med at dens muligheder bevares.

Oprindeligt designet til at øge effektiviteten og reducere beregningsomkostningerne, destillation er blevet en meget brugt praksis i AI-udvikling. Men, når det gøres uden behørig autorisation - såsom at udvinde viden fra proprietære AI-modeller - rejser det alvorlige etiske og juridiske bekymringer.

”Vi er opmærksomme på, at grupper i [Porcelæn] arbejder aktivt på replikere avanceret USA. AI modeller gennem teknikker som destillation,” fortalte en OpenAI-repræsentant til The Guardian.

Med DeepSeeks hurtige vækst i AI-sektoren, bekymringer omkring dets sikkerhed, overholdelse af lovgivningen, og etisk datapraksis er blevet intensiveret. Virksomhedens tilgang til disse spørgsmål vil være en nøglefaktor for at skabe dens langsigtede succes i det globale AI-landskab.