Pour chaque utilisateur de Google Analytics, il est important de distinguer le trafic Internet d'un site Web - le réel de l'artificiel. Il existe des programmes informatiques conçus pour effectuer des tâches automatiques sur Internet, bots, qui peut générer beaucoup de trafic sur un site web. Si, dans cet article, vous apprendrez ce que vous pouvez faire, à exclure que le trafic généralement indésirables.

À la fin de l'année dernière, il y avait des rapports officiels qui indiquent que seulement environ "50% du trafic web"Provient de vrais êtres humains. Voilà un problème, surtout avec un si grand nombre "Moteurs de recherche»Autour de qui peut vous empêcher de découvrir ce qui est le trafic réel pour tous vos sites.

Moteurs de recherche Internet sont conçus pour effectuer des tâches simples et répétitives sur une base automatique, qui sont fastidieux, voire impossible pour les gens à faire. La plus grande utilisation de ces "Moteurs de recherche" est dans Spidering Web. UN "Araignée", aussi connu comme "Robot d'indexation Web"Est un script qui récupère, les analyses et les fichiers des informations spécifiques à partir des serveurs beaucoup plus rapidement que tout être humain peut faire web. Il est appelé que parce qu'il se traîne sur le Web.

Dans le passé, un moyen efficace pour arrêter l'influence de bots sur les statistiques de trafic était de Google Analytics utiliser JavaScript, car les robots ne pouvait pas. Aujourd'hui, il ya même des robots «intelligents», qui peut utiliser avec succès JavaScript, et dérivation que la technique de la prévention dans Google Analytics.

Outre ces bots, il ya les méchants. Certains robots sont conçus pour causer "Déni de service (DoS)"Attaques, tandis que d'autres messages de spam indépendants sur vos sites avec lien qui peut contenir du code malveillant, Quelles sont les autres raisons valables de ne pas vouloir bot-robots sur vos pages web.

Voici 5 méthodes d'exclure tout le bot trafic généré par Google Analytics:

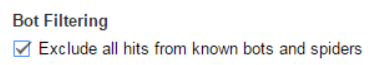

Méthode #1 - Activer Bot Filtrage du panneau d'administration

Il ya une case à l'intérieur de Google Analytics qui peuvent être cochées pour enlever les robots connus. Il est situé à l'intérieur de la "Administrateur" panneau, en dessous de "Vue«Paramètres et la case à cocher est nommé"Bot Filtrage". Il est conseillé de d'abord faire une Test de, avant de quitter la case cochée dans la déclaration principale Vue. De cette façon, vous pouvez repérer quelles différences vous repérer dans vos résultats de la collecte de données.

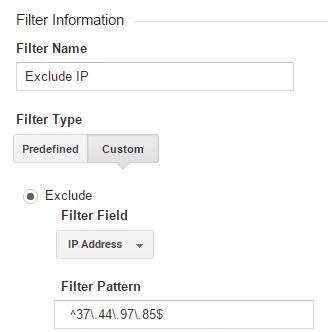

Méthode #2 – Filtrez adresses IP spécifiques

Les adresses IP ne sont pas affichés en Google Analytics rapports. Ils ne sont pas disponibles pour être vu à travers JavaScript par défaut, mais vous devriez être capable de configurer et activer cette fonctionnalité sur votre site avec beaucoup d'aisance. Après avoir récupéré toutes les adresses IP que vous souhaitez exclure d'être analysé dans les données du trafic Internet, il est temps de bloquer ceux. Vous pouvez le faire en utilisant le "Voir Filtres"Menu à l'intérieur Google Analytics.

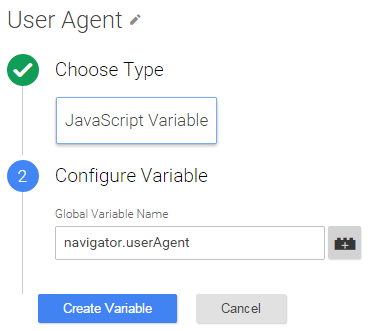

Méthode #3 - Ajout d'une variable JavaScript pour les agents utilisateurs

Même si vous bloquez IP spécifiques, certains robots peuvent utiliser plusieurs adresses IP et basculer entre eux. Avec l'aide de "Google Gestionnaire de balises"Est possible de passer tous “Agent utilisateur” cordes dans Google Analytics comme une dimension personnalisée. Après, vous pouvez exclure les sessions de bots.

Créer "Dimension personnalisée" dans le "Administrateur"Panel de Google Analytics. Assurez-vous que le nom est "Agent utilisateur»Et rendre la portée"Session". Pars "Indice"Intacte pour l'instant.

Dans Google Tag Manager établit un nouveau "JavaScript variable" avec navigator.userAgent valeur.

Régler une fente de variable personnalisé pour votre "Google Analytics Pageview Tag", en utilisant l '«Indice» mentionné ci-dessus. Entrer le {{Agent utilisateur}} dans variable "Dimension Valeur".

Dans "Administrateur> Voir> Filtres"Vous pouvez éliminer"Agents de l'utilisateur"Qui sont connus pour être des robots, en raison de leur comportement bizarre, comme les utilisateurs ayant des taux de rebond de répétition ou d'autres utilisateurs ayant des centaines de visites par jour.

Méthode #4 - Ajouter une exigence de CAPTCHA

Pour rendre les choses plus difficile pour les robots qui continuent à entrer dans votre site malgré les mesures de précaution déjà prises, vous devez utiliser une sorte de "Captcha". Il est recommandé d'utiliser Google propre "reCAPTCHA"Service et la variante plus récente, appelée"noCAPTCHA". Il détecte le comportement humain qui est typique, y compris l'utilisation de la souris, permettant aux personnes de ne pas avoir besoin d'entrer un message captcha du tout.

Méthode #5 - Obliger les utilisateurs à valider leurs e-mails

Les utilisateurs devraient être tenus d'entrer une adresse email valide, vérifier leur e-mail, et cliquez sur le lien de confirmation avec un message que vous avez dit. Il ya Moteurs de recherche très sophistiqués qui peuvent même le faire, donc une dernière chose que vous devez faire est d'ajouter un "reCAPTCHA" ici aussi. Telle une avec reconnaissance d'image:

Cela devrait résumer moyens les plus efficaces pour exclure tous les hits de l'Internet Moteurs de recherche et araignées dans Google Analytics pour votre site(s). Vous devriez voir un changement notable dans votre collection de données des résultats d'analyse, après la mise en œuvre chaque méthode décrite ci-dessus. Et vous aurez également éviter Les attaques DDoS contre les robots collecteurs malveillants ainsi. Si, résumer, toutes ces méthodes sont un moyen viable pour lutter contre les robots collecteurs et sont nécessaires pour chaque Google Analytics utilisateur.