Ricerca profonda, un'intelligenza artificiale cinese in rapida crescita (AI) startup che ha recentemente guadagnato ampia attenzione, ha lasciato inavvertitamente uno dei suoi database esposto online. Questa falla nella sicurezza potrebbe aver dato ai criminali informatici l'accesso a informazioni altamente sensibili.

Secondo ricercatore di sicurezza Gal Nagli di Wiz, il database ClickHouse non configurato correttamente ha concesso il pieno controllo amministrativo, rendendo possibile agli utenti non autorizzati di accedere ai dati interni senza restrizioni.

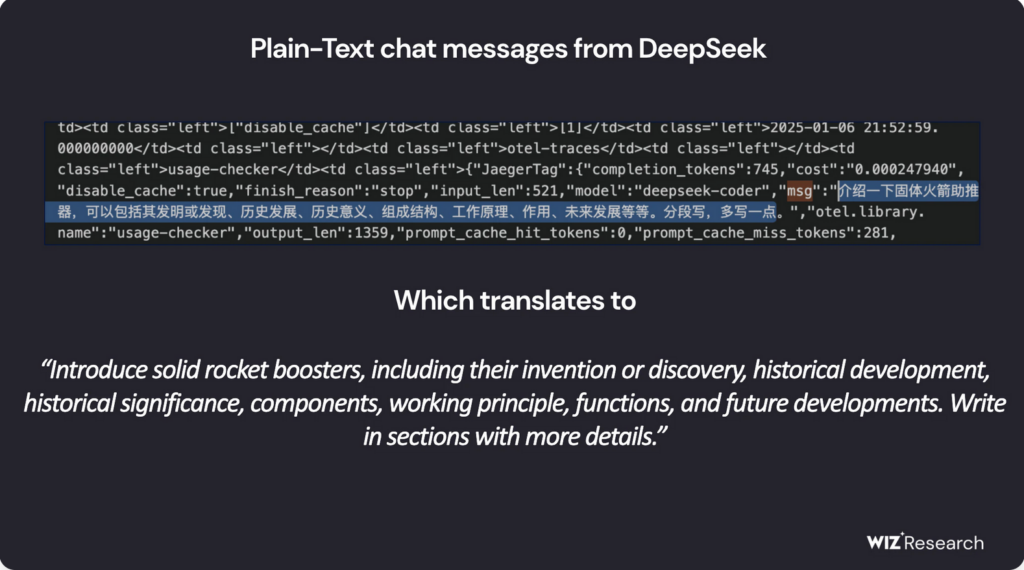

Il database esposto conteneva presumibilmente oltre un milione di linee di flussi di log, comprese le cronologie delle chat, dettagli del backend, Segreti API, chiavi segrete, e altri metadati operativi critici. Dopo molteplici tentativi di contatto da parte di Wiz, Da allora DeepSeek ha protetto la vulnerabilità.

Vale la pena ricordare che al momento della pubblicazione di questo articolo, non siamo riusciti a registrarci al servizio DeepSeek AI, come è apparso il seguente messaggio:

DeepSeek consente l'accesso illimitato ai dati sensibili

Il database compromesso, ospitato su oauth2callback.deepseek[.]con:9000 e dev.deepseek[.]con:9000, consentito l'ingresso senza restrizioni a un ampio spettro di dati riservati. I ricercatori di Wiz hanno avvertito che l'esposizione avrebbe potuto portare al controllo completo del database, non autorizzato aumento dei privilegi, e sfruttamento dei dati – senza bisogno di alcuna autenticazione.

Inoltre, gli aggressori avrebbero potuto utilizzare l'interfaccia HTTP di ClickHouse per eseguire query SQL direttamente da un browser web. A questo punto, non è ancora chiaro se qualche malintenzionato sia riuscito a infiltrarsi o estrarre i dati esposti prima che il problema fosse risolto.

“La rapida adozione di servizi di intelligenza artificiale senza adeguate misure di sicurezza presenta gravi rischi," ha affermato Nagli in un commento a The Hacker News. “Mentre le discussioni sulla sicurezza dell’IA spesso si concentrano sulle minacce a lungo termine, I pericoli immediati spesso derivano da sviste fondamentali sulla sicurezza, come l’esposizione accidentale del database”.

Ha inoltre sottolineato che la protezione dei dati degli utenti deve rimanere una priorità assoluta, sollecitando i team di sicurezza a collaborare strettamente con gli sviluppatori di intelligenza artificiale per prevenire incidenti simili in futuro.

DeepSeek sotto esame normativo

DeepSeek ha recentemente ottenuto riconoscimenti per i suoi modelli di intelligenza artificiale open source all'avanguardia, posizionandosi come un formidabile concorrente per i leader del settore come OpenAI. Il suo modello di ragionamento R1 è stato soprannominato “il momento Sputnik dell’IA” per il suo potenziale di sconvolgere il campo.

Il chatbot AI dell'azienda ha guadagnato popolarità, in cima alle classifiche degli app store sia su Android che su iOS in più paesi. Tuttavia, la sua rapida espansione l'ha resa anche un bersaglio per attacchi informatici su larga scala, spingendo DeepSeek a sospendere temporaneamente le registrazioni degli utenti per mitigare le minacce alla sicurezza.

Oltre le vulnerabilità tecniche, la società è stata anche sottoposta a controllo normativo. Preoccupazioni sulla privacy relative alle pratiche sui dati di DeepSeek, accoppiato con il suo Origini cinesi, hanno sollevato allarmi per la sicurezza nazionale negli Stati Uniti.

Sfide legali

In uno sviluppo significativo, L'autorità di controllo della protezione dei dati italiana ha recentemente richiesto dettagli sui metodi di raccolta dati e sulle fonti di formazione di DeepSeek. Poco dopo, le app dell'azienda non sono più disponibili in Italia, sebbene non sia ancora chiaro se questa mossa sia stata una risposta diretta alle richieste di regolamentazione.

Nel frattempo, DeepSeek sta anche affrontando accuse secondo cui potrebbe aver sfruttato in modo improprio l'interfaccia di programmazione delle applicazioni di OpenAI (API) per sviluppare i propri modelli. Rapporti da Bloomberg, Il Financial Times, e il Wall Street Journal indicano che sia OpenAI che Microsoft stanno indagando se DeepSeek sia coinvolta in una pratica non autorizzata nota come distillazione dell'IA, una tecnica che prevede la formazione di modelli su output generati da un altro sistema di intelligenza artificiale.

Maggiori informazioni sulla distillazione AI

Distillazione AI, noto anche come distillazione della conoscenza, è una tecnica di apprendimento automatico in cui un numero più piccolo, un modello di intelligenza artificiale più efficiente viene addestrato utilizzando gli output di un sistema più ampio, modello più complesso. Questo metodo consente agli sviluppatori di trasferire le conoscenze da una potente intelligenza artificiale (il modello dell'insegnante) ad un'intelligenza artificiale leggera (il modello studentesco) pur preservandone le capacità.

Originariamente progettato per migliorare l'efficienza e ridurre i costi computazionali, la distillazione è diventata una pratica ampiamente utilizzata nello sviluppo dell'intelligenza artificiale. Tuttavia, quando fatto senza la dovuta autorizzazione, come l’estrazione di conoscenze da modelli di intelligenza artificiale proprietari, solleva gravi preoccupazioni etiche e legali.

“Siamo consapevoli che i gruppi in [Porcellana] stanno lavorando attivamente per replicare gli Stati Uniti avanzati. Modelli di intelligenza artificiale attraverso tecniche come la distillazione," ha detto un rappresentante di OpenAI al The Guardian.

Con la rapida crescita di DeepSeek nel settore dell'intelligenza artificiale, preoccupazioni sulla sua sicurezza, conformità normativa, e le pratiche etiche sui dati si sono intensificate. L'approccio dell'azienda a queste problematiche sarà un fattore chiave per determinare il suo successo a lungo termine nel panorama globale dell'intelligenza artificiale..