Busca Profunda, uma inteligência artificial chinesa de rápido crescimento (AI) startup que recentemente ganhou grande atenção, deixou inadvertidamente um de seus bancos de dados exposto online. Esta falha de segurança pode ter dado aos cibercriminosos acesso a informações altamente confidenciais.

De acordo com pesquisador de segurança Gal Nagli da Wiz, o banco de dados ClickHouse mal configurado concedeu controle administrativo total, possibilitando que usuários não autorizados acessem dados internos sem restrições.

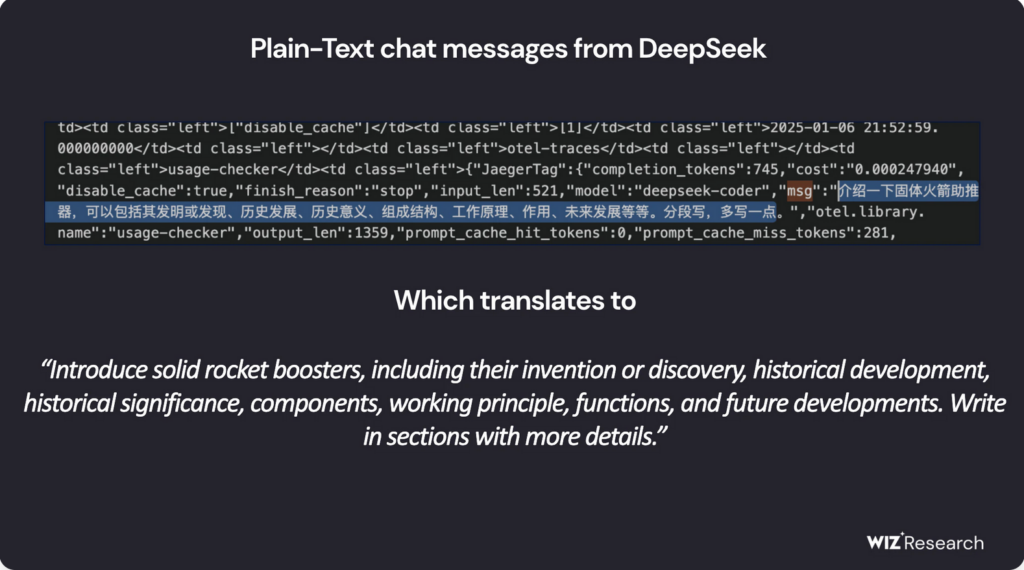

O banco de dados exposto supostamente continha mais de um milhão de linhas de fluxos de log, incluindo históricos de bate-papo, detalhes do backend, Segredos da API, chaves secretas, e outros metadados operacionais críticos. Após várias tentativas de contato do Wiz, O DeepSeek já protegeu a vulnerabilidade.

Vale ressaltar que na época da publicação deste artigo, não conseguimos registrar o serviço do DeepSeek AI, como a seguinte mensagem apareceu:

DeepSeek permite acesso irrestrito a dados confidenciais

O banco de dados comprometido, hospedado em oauth2callback.deepseek[.]com:9000 e dev.deepseek[.]com:9000, permitiu a entrada irrestrita em um amplo espectro de dados confidenciais. Pesquisadores do Wiz alertaram que a exposição poderia ter levado ao controle completo do banco de dados, não autorizado escalação de privilégios, e exploração de dados – sem a necessidade de qualquer autenticação.

além disso, os invasores poderiam ter usado a interface HTTP do ClickHouse para executar consultas SQL diretamente de um navegador da web. Neste ponto, permanece incerto se algum agente malicioso conseguiu infiltrar-se ou extrair os dados expostos antes que o problema fosse resolvido.

“A rápida adopção de serviços de IA sem medidas de segurança adequadas apresenta sérios riscos,” Nagli afirmou em um comentário ao The Hacker News. “Embora as discussões sobre a segurança da IA se concentrem frequentemente em ameaças de longo prazo, perigos imediatos frequentemente decorrem de omissões fundamentais de segurança, como exposição acidental de bancos de dados.”

Ele enfatizou ainda que a proteção dos dados dos usuários deve continuar sendo uma prioridade máxima, instando as equipes de segurança a trabalhar em estreita colaboração com os desenvolvedores de IA para evitar incidentes semelhantes no futuro.

DeepSeek sob escrutínio regulatório

A DeepSeek ganhou recentemente reconhecimento por seus modelos de IA de código aberto de ponta, posicionando-se como um concorrente formidável para líderes da indústria como OpenAI. Seu modelo de raciocínio R1 foi apelidado de “momento Sputnik da IA” por seu potencial de perturbar o campo.

O chatbot de IA da empresa ganhou popularidade, no topo do ranking da app store no Android e iOS em vários países. Contudo, sua rápida expansão também a tornou um alvo para ataques cibernéticos em larga escala, levando o DeepSeek a suspender temporariamente os registros de usuários para mitigar ameaças à segurança.

Além das vulnerabilidades técnicas, a empresa também atraiu o escrutínio regulatório. Preocupações com a privacidade em torno das práticas de dados da DeepSeek, juntamente com seu Origens chinesas, levantaram alarmes de segurança nacional nos Estados Unidos.

Desafios Legais

Num desenvolvimento significativo, O regulador de proteção de dados da Itália solicitou recentemente detalhes sobre os métodos de coleta de dados e fontes de treinamento do DeepSeek. Pouco depois, os aplicativos da empresa ficaram indisponíveis na Itália, embora ainda não esteja claro se esta medida foi uma resposta directa a inquéritos regulamentares.

enquanto isso, O DeepSeek também enfrenta alegações de que pode ter aproveitado indevidamente a interface de programação de aplicativos do OpenAI (API) para desenvolver seus próprios modelos. Relatórios da Bloomberg, O Financial Times, e o The Wall Street Journal indicam que tanto a OpenAI quanto a Microsoft estão investigando se a DeepSeek se envolveu em uma prática não autorizada conhecida como destilação de IA — uma técnica que envolve modelos de treinamento em saídas geradas por outro sistema de IA.

Mais sobre destilação de IA

Destilação de IA, também conhecido como destilação do conhecimento, é uma técnica de aprendizado de máquina onde um menor, um modelo de IA mais eficiente é treinado usando as saídas de um modelo maior, modelo mais complexo. Este método permite que os desenvolvedores transfiram conhecimento de uma IA poderosa (o modelo do professor) para uma IA leve (o modelo do aluno) preservando ao mesmo tempo as suas capacidades.

Originalmente projetado para aumentar a eficiência e reduzir custos computacionais, a destilação se tornou uma prática amplamente utilizada no desenvolvimento de IA. Contudo, quando feito sem autorização adequada — como extrair conhecimento de modelos proprietários de IA — levanta sérias preocupações éticas e legais.

“Temos consciência de que grupos em [China] estão trabalhando ativamente para replicar EUA avançado. Modelos de IA através de técnicas como a destilação,“um representante da OpenAI disse ao The Guardian.

Com o rápido crescimento da DeepSeek no setor de IA, preocupações em torno da sua segurança, conformidade regulatória, e as práticas éticas de dados se intensificaram. A abordagem da empresa a essas questões será um fator-chave na formação de seu sucesso a longo prazo no cenário global da IA.