DeepSeek, eine schnell wachsende chinesische künstliche Intelligenz (AI) Startup, das kürzlich große Aufmerksamkeit erlangte, versehentlich eine seiner Datenbanken online zugänglich gemacht. Diese Sicherheitslücke hätte Cyberkriminellen Zugang zu hochsensiblen Informationen verschaffen können.

Nach Sicherheitsforscher Gal Nagli von Wiz, die falsch konfigurierte ClickHouse-Datenbank gewährt volle administrative Kontrolle, Unberechtigten Benutzern den uneingeschränkten Zugriff auf interne Daten zu ermöglichen.

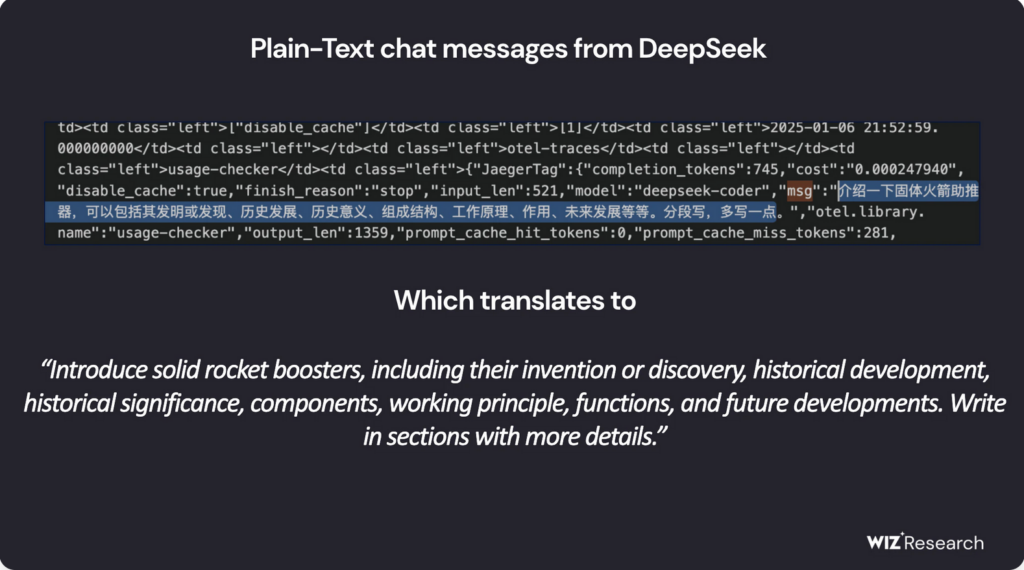

Die offengelegte Datenbank enthielt angeblich über eine Million Zeilen an Log-Streams, inklusive Chatverläufen, Backend-Details, API-Geheimnisse, geheime Schlüssel, und andere kritische Betriebsmetadaten. Nach mehreren Kontaktversuchen von Wiz, DeepSeek hat die Schwachstelle inzwischen behoben.

Es ist erwähnenswert, dass zum Zeitpunkt der Veröffentlichung dieses Artikels, Wir konnten uns nicht für den Dienst von DeepSeek AI registrieren, als die folgende Meldung angezeigt wurde:

DeepSeek ermöglicht uneingeschränkten Zugriff auf sensible Daten

Die kompromittierte Datenbank, gehostet auf oauth2callback.deepseek[.]mit:9000 und dev.deepseek[.]mit:9000, erlaubt uneingeschränkten Zugang zu ein breites Spektrum vertraulicher Daten. Wiz-Forscher warnten, dass die Offenlegung zur vollständigen Datenbankkontrolle hätte führen können, unbefugt privilege escalation, und Datenverwertung – ohne dass eine Authentifizierung erforderlich ist.

Weiter, Angreifer hätten die HTTP-Schnittstelle von ClickHouse nutzen können, um Ausführen von SQL-Abfragen direkt aus einem Webbrowser. An dieser Stelle, Es bleibt unklar, ob es böswilligen Akteuren gelungen ist, die offengelegten Daten zu infiltrieren oder zu extrahieren, bevor das Problem behoben wurde..

„Die schnelle Einführung von KI-Diensten ohne angemessene Sicherheitsmaßnahmen birgt ernsthafte Risiken,” erklärte Nagli in einem Kommentar gegenüber The Hacker News. „Während sich Diskussionen über KI-Sicherheit oft auf langfristige Bedrohungen konzentrieren, Unmittelbare Gefahren resultieren häufig aus grundlegenden Sicherheitsversehen – beispielsweise einer versehentlichen Offenlegung von Datenbanken.“

Er betonte weiter, dass der Schutz der Benutzerdaten weiterhin oberste Priorität haben müsse., Sicherheitsteams werden aufgefordert, eng mit KI-Entwicklern zusammenzuarbeiten, um ähnliche Vorfälle in Zukunft zu verhindern.

DeepSeek unter behördlicher Beobachtung

DeepSeek hat kürzlich Anerkennung für seine innovativen Open-Source-KI-Modelle erhalten, positioniert sich als starker Konkurrent für Branchenführer wie OpenAI. Sein R1-Argumentationsmodell wurde aufgrund seines Potenzials, das Feld zu revolutionieren, als „Sputnik-Moment der KI“ bezeichnet.

Der KI-Chatbot des Unternehmens erfreut sich zunehmender Beliebtheit, Spitzenreiter der App Store-Rankings für Android und iOS in mehreren Ländern. Jedoch, Seine schnelle Expansion machte es auch zum Ziel für groß angelegte Cyberangriffe, DeepSeek veranlasste die vorübergehende Aussetzung der Benutzerregistrierung, um Sicherheitsbedrohungen zu mindern.

Über technische Schwachstellen hinaus, Das Unternehmen ist auch ins Visier der Aufsichtsbehörden geraten. Datenschutzbedenken im Zusammenhang mit DeepSeeks Datenpraktiken, gepaart mit seiner Chinesische Ursprünge, haben in den Vereinigten Staaten nationale Sicherheitsalarme ausgelöst.

Rechtliche Herausforderungen

In einer bedeutenden Entwicklung, Italiens Datenschutzbehörde hat kürzlich Einzelheiten zu DeepSeeks Datenerfassungsmethoden und Schulungsquellen angefordert. Kurz danach, Die Apps des Unternehmens waren in Italien nicht mehr verfügbar, Es bleibt jedoch unklar, ob dieser Schritt eine direkte Reaktion auf behördliche Anfragen war.

Mittlerweile, DeepSeek sieht sich außerdem mit Vorwürfen konfrontiert, dass es die Anwendungsprogrammierschnittstelle von OpenAI möglicherweise unzulässig genutzt hat. (API) eigene Modelle zu entwickeln. Berichte von Bloomberg, Die Financial Times, und das Wall Street Journal geben an, dass sowohl OpenAI als auch Microsoft untersuchen, ob DeepSeek eine nicht autorisierte Praxis namens „AI Distillation“ angewandt hat – eine Technik, bei der Modelle anhand von Ergebnissen trainiert werden, die von einem anderen KI-System generiert werden..

Mehr zur KI-Destillation

KI-Destillation, alias Wissensdestillation, ist eine Technik des maschinellen Lernens, bei der ein kleinerer, Ein effizienteres KI-Modell wird mit den Ergebnissen eines größeren, komplexeres Modell. Mit dieser Methode können Entwickler Wissen aus einer leistungsstarken KI übertragen (das Lehrermodell) zu einer leichtgewichtigen KI (das Studentenmodell) unter Beibehaltung seiner Fähigkeiten.

Ursprünglich entwickelt, um die Effizienz zu steigern und den Rechenaufwand zu senken, Destillation ist zu einer weit verbreiteten Praxis in der KI-Entwicklung geworden. Jedoch, Wenn dies ohne entsprechende Genehmigung geschieht – wie etwa bei der Extraktion von Wissen aus proprietären KI-Modellen – wirft es ernsthafte ethische und rechtliche Bedenken auf.

„Wir sind uns bewusst, dass Gruppen in [China] arbeiten aktiv daran, replizieren fortgeschrittene US. KI-Modelle durch Techniken wie Destillation,“, sagte ein OpenAI-Vertreter gegenüber The Guardian.

Mit DeepSeeks schnellem Wachstum im KI-Sektor, Bedenken hinsichtlich seiner Sicherheit, Einhaltung gesetzlicher Vorschriften, und ethische Datenpraktiken haben sich intensiviert. Die Herangehensweise des Unternehmens an diese Themen wird ein Schlüsselfaktor für seinen langfristigen Erfolg in der globalen KI-Landschaft sein..